Gemma 한영번역 LoRA 파인튜닝 빠른실행

이번에는 Gemma를 “databricks-dolly-15k.jsonl”과 “databricks-dolly-15k-ko.jsonl” 데이터셋을 이용해서 한영번역 LoRA 파인튜닝을 해보도록 하겠습니다.

함께보기

- 1편 - Gemma 시작하기 빠른실행 (추후 공개)

- 2편 - Gemma LoRA 파인튜닝 빠른실행

- 3편 - Gemma 한국어 LoRA 파인튜닝 빠른실행

- 4편 - Gemma 영한번역 LoRA 파인튜닝 빠른실행

- 5편 - Gemma 한영번역 LoRA 파인튜닝 빠른실행

- 6편 - Gemma 한국어 SQL챗봇 LoRA 파인튜닝 빠른실행

- 7편 - Gemma 온디바이스 탑재 - 웹브라우저편 빠른실행

- 8편 - Gemma 온디바이스 탑재 - 아이폰(iOS)편 빠른실행

- 9편 - Gemma 온디바이스 탑재 - 안드로이드편 빠른실행 (작업중)

- 10편 - RLHF 튜닝으로 향상된 Gemma 1.1 2B IT 공개

- 11편 - 소스코드 생성 전용 - CodeGemma 시작하기

databricks-dolly-15k 데이터셋

databricks-dolly-15k는 2023년 3월과 4월에 Databricks의 5,000명 이상의 직원이 작성한 15,000개의 고품질 인간 생성 프롬프트/응답 쌍을 포함하는 데이터셋입니다. 이 데이터셋은 큰 언어 모델의 지시 튜닝을 위해 특별히 설계되었으며, 훈련 레코드는 자연스럽고 표현력이 풍부하여 브레인스토밍 및 콘텐츠 생성부터 정보 추출 및 요약에 이르기까지 다양한 행동을 대표하도록 설계되었습니다

databricks-dolly-15k-ko 데이터셋

databricks-dolly-15k-ko 데이터셋은 허깅페이스에서 다운로드 받을 수 있으며, NLP & AI - Korea University에서 databricks-dolly-15k를 DeepL API를 이용해서 한국어 번역을 수행한 파일입니다.

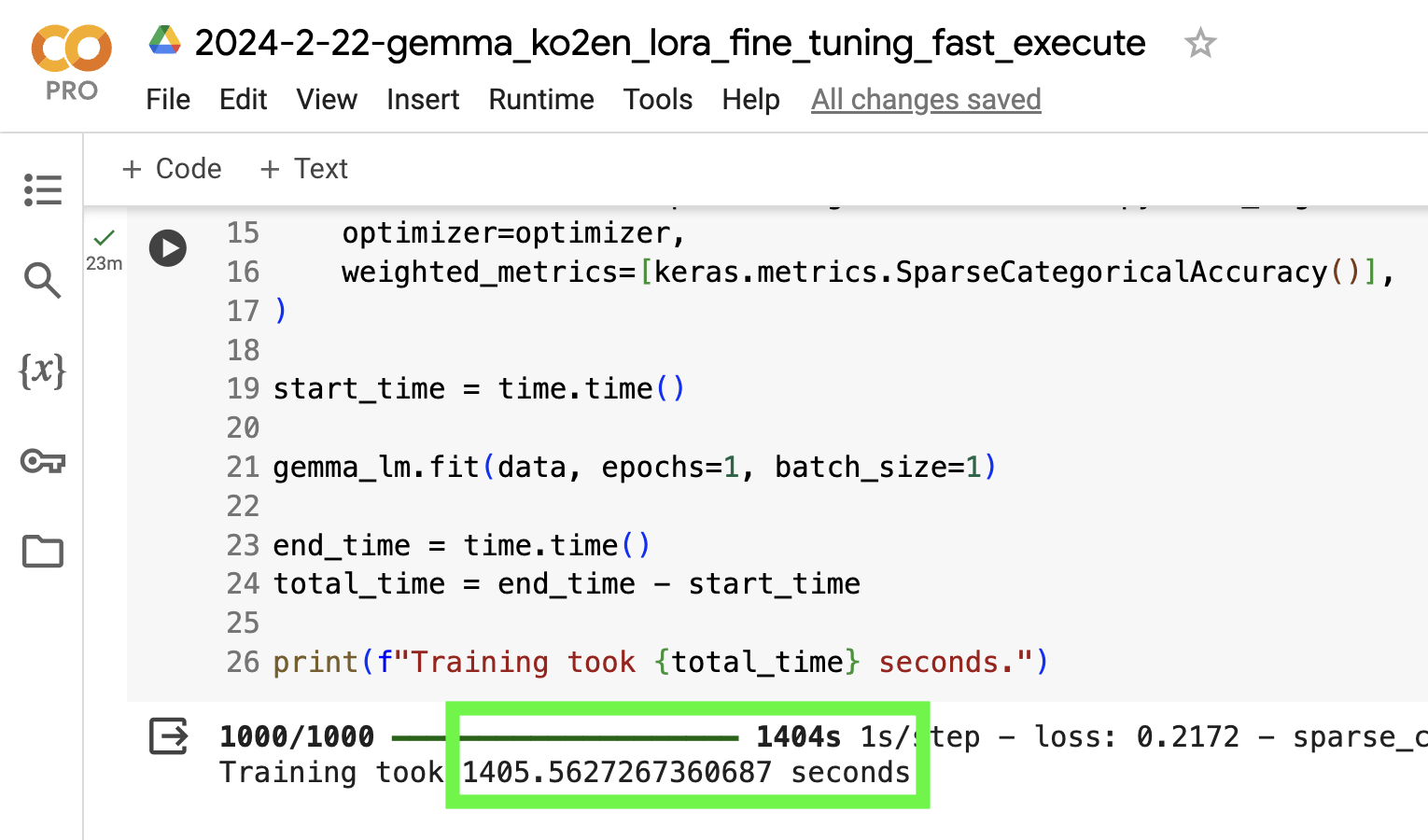

학습시간

LoRA 랭크 4로 1 에포크 시에 23.4분이 소요되었습니다. 사양은 구글코랩 T4입니다.

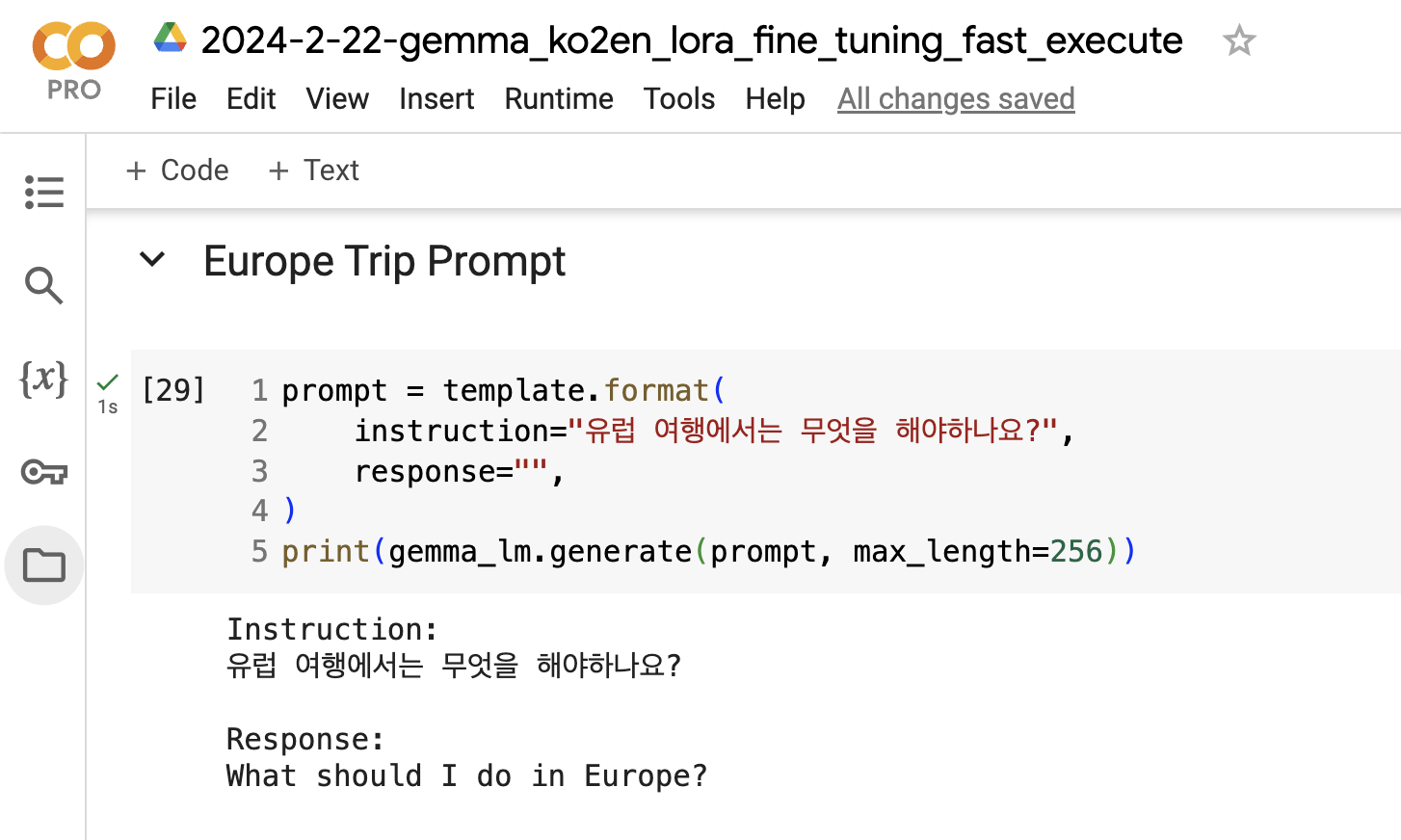

수행결과 1

Instruction:

유럽 여행에서는 무엇을 해야하나요?

Response:

What should I do in Europe?

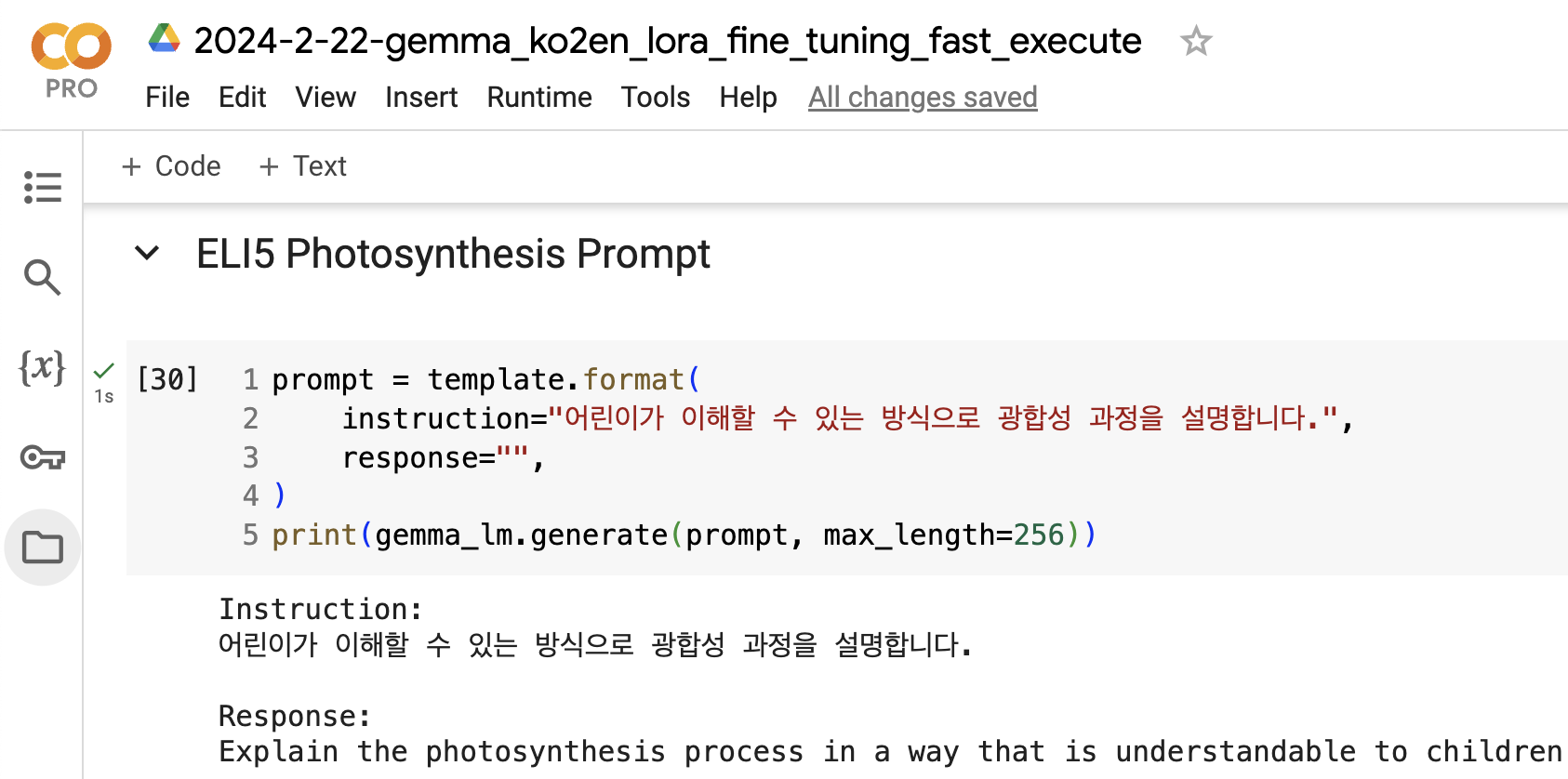

수행결과 2

Instruction:

어린이가 이해할 수 있는 방식으로 광합성 과정을 설명합니다.

Response:

Explain the photosynthesis process in a way that is understandable to children

수행결과 3

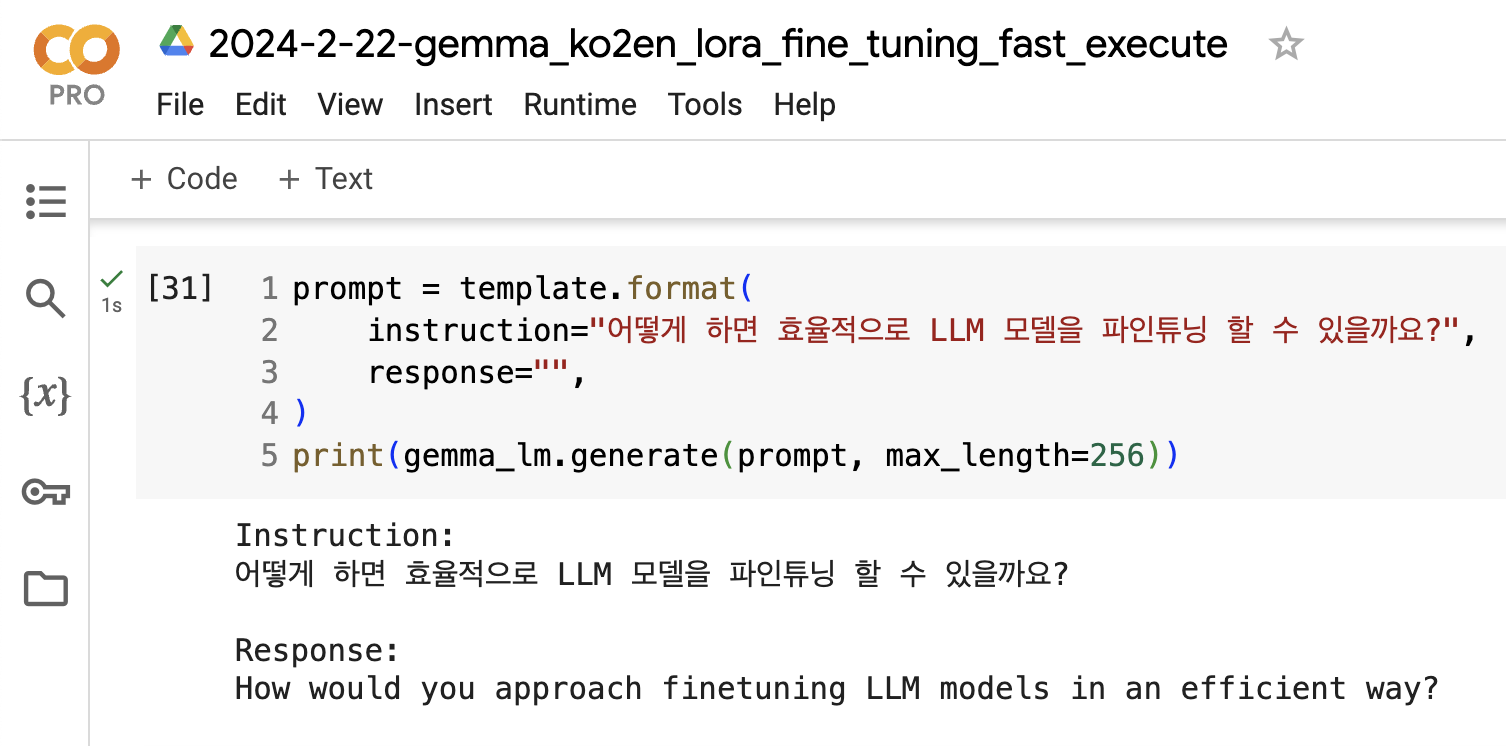

Instruction:

어떻게 하면 효율적으로 LLM 모델을 파인튜닝 할 수 있을까요?

Response:

How would you approach finetuning LLM models in an efficient way?

더보기

LoRA 파인튜닝 공식 예제는 다음과 같습니다.

추가문의

- 작성자 : 김태영

- 이메일 : tykim@aifactory.page

함께보기

- 1편 - Gemma 시작하기 빠른실행 (추후 공개)

- 2편 - Gemma LoRA 파인튜닝 빠른실행

- 3편 - Gemma 한국어 LoRA 파인튜닝 빠른실행

- 4편 - Gemma 영한번역 LoRA 파인튜닝 빠른실행

- 5편 - Gemma 한영번역 LoRA 파인튜닝 빠른실행

- 6편 - Gemma 한국어 SQL챗봇 LoRA 파인튜닝 빠른실행

- 7편 - Gemma 온디바이스 탑재 - 웹브라우저편 빠른실행

- 8편 - Gemma 온디바이스 탑재 - 아이폰(iOS)편 빠른실행

- 9편 - Gemma 온디바이스 탑재 - 안드로이드편 빠른실행 (작업중)

- 10편 - RLHF 튜닝으로 향상된 Gemma 1.1 2B IT 공개

- 11편 - 소스코드 생성 전용 - CodeGemma 시작하기

책 소개

[추천사]

- 하용호님, 카카오 데이터사이언티스트 - 뜬구름같은 딥러닝 이론을 블록이라는 손에 잡히는 실체로 만져가며 알 수 있게 하고, 구현의 어려움은 케라스라는 시를 읽듯이 읽어내려 갈 수 있는 라이브러리로 풀어준다.

- 이부일님, (주)인사아트마이닝 대표 - 여행에서도 좋은 가이드가 있으면 여행지에 대한 깊은 이해로 여행이 풍성해지듯이 이 책은 딥러닝이라는 분야를 여행할 사람들에 가장 훌륭한 가이드가 되리라고 자부할 수 있다. 이 책을 통하여 딥러닝에 대해 보지 못했던 것들이 보이고, 듣지 못했던 것들이 들리고, 말하지 못했던 것들이 말해지는 경험을 하게 될 것이다.

- 이활석님, 네이버 클로바팀 - 레고 블럭에 비유하여 누구나 이해할 수 있게 쉽게 설명해 놓은 이 책은 딥러닝의 입문 도서로서 제 역할을 다 하리라 믿습니다.

- 김진중님, 야놀자 Head of STL - 복잡했던 머릿속이 맑고 깨끗해지는 효과가 있습니다.

- 이태영님, 신한은행 디지털 전략부 AI LAB - 기존의 텐서플로우를 활용했던 분들에게 바라볼 수 있는 관점의 전환점을 줄 수 있는 Mild Stone과 같은 책이다.

- 전태균님, 쎄트렉아이 - 케라스의 특징인 단순함, 확장성, 재사용성을 눈으로 쉽게 보여주기 위해 친절하게 정리된 내용이라 생각합니다.

- 유재준님, 카이스트 - 바로 적용해보고 싶지만 어디부터 시작할지 모를 때 최선의 선택입니다.